去年的GTC大會上,Nvidia推出了基於Pascal架構的GPU加速器Tesla P100,以及採用這套產品的AI應用伺服器DGX-1,今年他們發表了基於新一代Volta架構的Tesla V100,而在整合設備上,他們並非翻新DGX-1的規格,而是增設了AI應用工作站DGX Station,擴大DGX AI超級電腦這條產品線的規模。

而在2017年新推出的DGX Station當中,最大賣點莫過於搭配了採用Vota架構的Tesla V100,可在單臺系統內,搭配4臺Tesla V100,提供相當於400顆CPU的效能,而相較於一般桌上型的工作站,可節省40%的耗電量,系統運作噪音也很低,大約是其他執行深度學習工作站系統的十分之一。

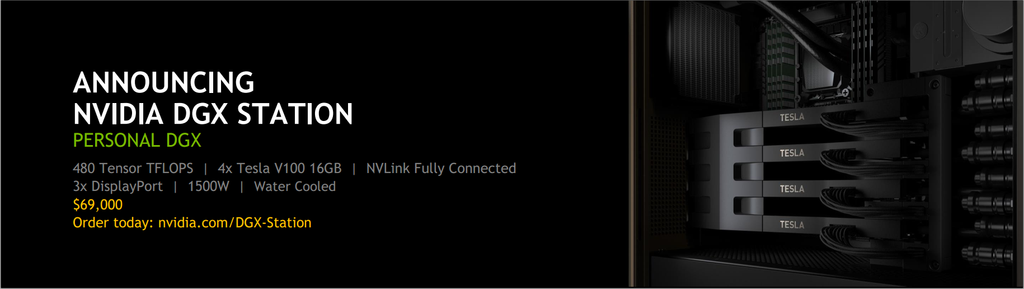

Nvidia在GTC大會上,發表了DGX Station,這臺直立式主機的AI整合應用工作站,搭配了4套Tesla V100的GPU加速器,運算能力可達到480 Tensor TFLOPS,當中也提供3個DisplayPort,可連接螢幕顯示裝置。

DGX Station機箱內部配置的情況如何?可區分成多個部位,我們來看看其中5個:

1.套GPU加速器Tesla V100:整合Tensor Core架構

2.連接GPU之間,以及CPU與GPU的介面NVLink 2.0:每顆GPU之間的頻寬為200 GB/s,是當前PCIe 3.0 x16的5倍

3.水冷裝置:針對桌面環境使用,不會因系統散熱需求而導致太大噪音。

4.中央處理器:配備Intel伺服器級處理器Xeon E5-2698 v4 2.2 GHz,用於系統開機、儲存管理,以及深度學習框架軟體的協調運作

5.DisplayPort埠,可支援4K解析度的螢幕輸出

至於另一款Nvidia去年推出的DGX-1,Nvidia也在今年的GTC大會上,宣布搭配剛出爐的Tesla V100。而在這款換裝新GPU加速器的設備上,Nvidia宣稱,提供的AI運算效能也跟著水漲船高,在半精度浮點運算(FP16)的部份,具備相當於800顆CPU的效能,相當於先前DGX-1設備的3倍以上。

左為今年發表的DGX Station,右為去年推出的DGX-1,皆可配備Tesla V100加速器。

就產品定位而言,DGX Station屬於個人端的超級電腦工作站,資料科學家可以以此進行運算密集的AI應用探索,像是訓練深度神經網路、推論處理與進階分析;而DGX-1適用於資料中心環境的大規模部署,可提供企業、雲端服務業者與研究機構導入。

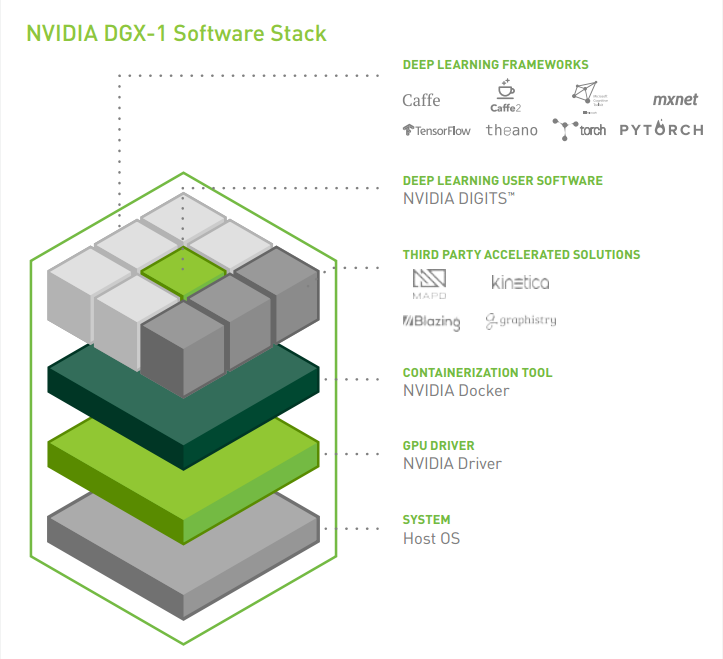

此外,兩者採用相同的軟體堆疊,資料科學家可以在DGX Station,進行AI應用的開發,以及深度學習與各種分析試驗,之後若需要更大的運作規模,可將這些工作無縫搬移到DGX-1伺服器叢集執行,不需要修改程式碼。

而這套軟體堆疊的執行效能,都已經由Nvida工程師進行調校,每月均會發布更新,用戶在當中可存取Nvidia DIGITS深度學應用程式、第三方解決方案(例如:MapD、BlazingDB、Kinetica、Graphistry),以及Nvidia Deep Learning SDK(包含cuDNN、cuBLAS)、CUDA toolkit工具包、fast multi-GPU collectives NCCL,以及Nvidia驅動程式。

同時,這些都是建構在Nvidia Docker環境內,提供統一的深度學習軟體堆疊,可減少相關的作業流程,並在用戶需要擴大執行規模時,節省軟體重新編譯的時間,並且能夠輕易地部署到資料中心或雲端服務上。

產品資訊

Nvidia DGX Station

●原廠:Nvidia(02)6605-5700

●建議售價:69,000美元

●機箱尺寸:直立式主機,518 x 256 x 639公釐

●處理器:20核心Intel Xeon E5-2698 v4 2.2 GHz

●系統記憶體:256 GB

●硬碟:4臺1.92 TB SSD(3臺RAID 0存放資料、1臺存放系統軟體)●GPU加速模組:4套Nvidia Tesla V100

●顯示介面:3個DisplayPort,支援4K解析度

●網路介面:2個10GbE埠

●軟體:Ubuntu Desktop Linux OS、DGX Recommended GPU Driver、CUDA Toolkit

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2024-04-22

2024-04-22

2024-04-22

2024-04-22

2024-04-22

2024-04-23